L'ebook a 40 ans > 1985 > Des extensions pour l'ASCII

Avec le développement de l’internet hors de la sphère anglophone, communiquer uniquement en anglais devient insuffisant, d’où la nécessité de prendre en compte les caractères accentués de plusieurs langues européennes et les caractères d’autres langues.

Le 18/05/2011 à 11:50 par Marie Lebert

0 Réactions | 0 Partages

Publié le :

18/05/2011 à 11:50

0

Commentaires

0

Partages

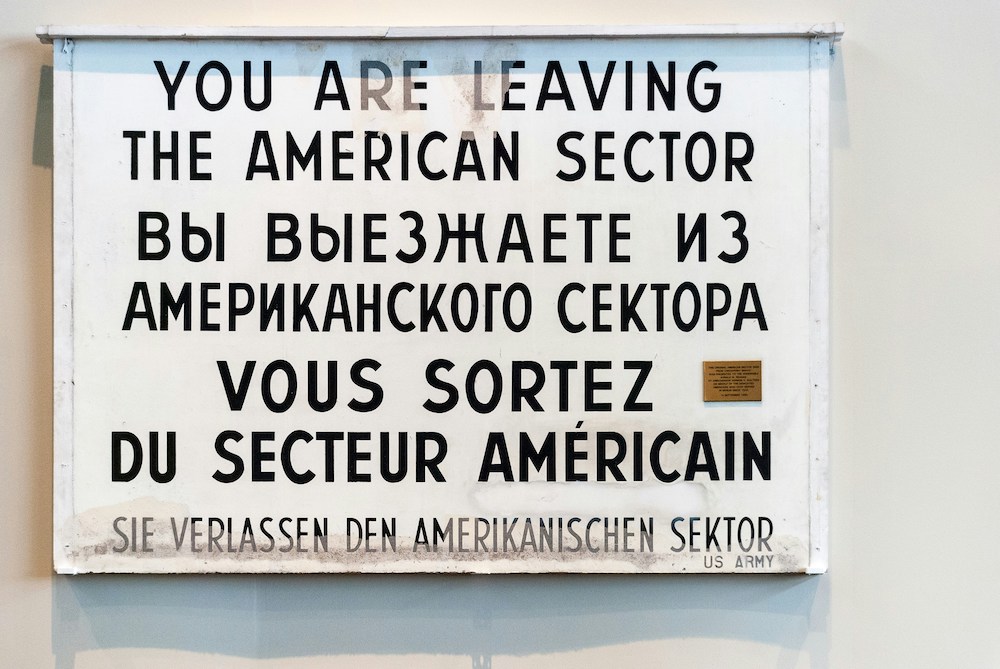

L’ASCII sur 7 bits

Le premier système d'encodage informatique est l’ASCII (American Standard Code for Information Interchange). Publié en 1968 aux États-Unis par l’American National Standards Institute (ANSI), l'ASCII est un code standard de 128 caractères traduits en langage binaire sur sept bits (A est traduit par «1000001», B est traduit par «1000010», etc.). Les 128 caractères comprennent 33 caractères de contrôle (qui ne représentent donc pas de symbole écrit) et 95 caractères imprimables: les 26 lettres sans accent en majuscules (A-Z) et minuscules (a-z), les chiffres, les signes de ponctuation et quelques caractères spéciaux, le tout correspondant aux touches du clavier anglophone.

L’ASCII sur 8 bits

L'ASCII permet uniquement la lecture de l’anglais (et du latin, mais à mon sens, peu de gens utilisent le latin pour communiquer via l’internet). L’ASCII ne permet donc pas de prendre en compte les lettres accentuées présentes dans bon nombre de langues européennes (français, espagnol, allemand, etc.), les langues disposant d’autres alphabets (arabe, grec, russe, etc.) et à plus forte raison les langues non alphabétiques (chinois, coréen, japonais, etc.).

Ceci ne pose pas de problème majeur les premières années, tant que l’échange de fichiers électroniques se limite surtout à l’Amérique du Nord. Mais le multilinguisme devient bientôt une nécessité vitale. Des variantes de l’ASCII (norme ISO-8859 ou ISO-Latin) sur huit bits sont publiées en 1985 pour prendre en compte les caractères accentués de quelques langues européennes. La variante pour le français, l’espagnol et l’allemand (entre autres) est la norme ISO-8859-1 (ISO-Latin-1).

Un véritable casse-tête

Avec le développement du web, l’échange des données s’internationalise encore davantage. Même avec des variantes de l’ASCII, on ne peut décidément plus se limiter à l’utilisation d’un système d’encodage datant des débuts de l’informatique. De plus, le passage de l’ASCII original à ses différentes extensions devient vite un véritable casse-tête, y compris au sein de l’Union européenne, les problèmes étant entre autres la multiplication des variantes, la corruption des données dans les échanges informatiques ou encore l’incompatibilité des systèmes, les pages ne pouvant être affichées que dans une seule langue à la fois.

Olivier Gainon, fondateur de CyLibris et pionnier de l’édition électronique littéraire, écrit à ce sujet en décembre 2000 : « Il faut que le réseau respecte les lettres accentuées, les lettres spécifiques, etc. Je crois très important que les futurs protocoles permettent une transmission parfaite de ces aspects - ce qui n’est pas forcément simple (dans les futures évolutions de l’HTML ou des protocoles IP, etc.). Donc il faut que chacun puisse se sentir à l’aise avec l’internet et que ce ne soit pas simplement réservé à des (plus ou moins) anglophones. Il est anormal aujourd’hui que la transmission d’accents puisse poser problème dans les courriers électroniques. La première démarche me semble donc une démarche technique. Si on arrive à faire cela, le reste en découle : la représentation des langues se fera en fonction du nombre de connectés, et il faudra envisager à terme des moteurs de recherche multilingues. » (Entretien du NEF)

L’Unicode

Publié pour la première fois en janvier 1991, l’Unicode est un système d'encodage universel sur 16 bits spécifiant un nombre unique pour chaque caractère. Ce nombre est lisible quels que soient la plateforme, le logiciel et la langue utilisés. L’Unicode peut traiter 65.000 caractères uniques et prendre en compte tous les systèmes d’écriture de la planète. L’Unicode est progressivement adopté à partir de 1998. L’introduction d’un nouveau système d’encodage représente en effet un énorme travail à tous niveaux, pour sa prise en compte dans tous les logiciels et tous les navigateurs web. (On y reviendra dans notre épisode d’après-demain, consacré à l’Unicode.)

Publié pour la première fois en janvier 1991, l’Unicode est un système d'encodage universel sur 16 bits spécifiant un nombre unique pour chaque caractère. Ce nombre est lisible quels que soient la plateforme, le logiciel et la langue utilisés. L’Unicode peut traiter 65.000 caractères uniques et prendre en compte tous les systèmes d’écriture de la planète. L’Unicode est progressivement adopté à partir de 1998. L’introduction d’un nouveau système d’encodage représente en effet un énorme travail à tous niveaux, pour sa prise en compte dans tous les logiciels et tous les navigateurs web. (On y reviendra dans notre épisode d’après-demain, consacré à l’Unicode.)

Notre prochain épisode: 1990 > Le web booste l’internet

Copyright © 2011 Marie Lebert

Plus d'articles sur le même thème

Des chevaux, des yourtes et nous : premiers pas en Mongolie

#AVeloEntreLesLignes – Partir à la découverte du plus grand nombre de librairies possible, entre Paris et Oulan-Bator, le défi est de taille. À vélo, c'est confirmé : c'est de la folie douce. C’est pourtant l’aventure que Zoé David-Rigot et Jaroslav Kocourek ont démarrée en août 2022. ActuaLitté les accompagne, en publiant leur récit de ce périple, À vélo, entre les lignes.

13/04/2024, 12:17

Pause soupe de nouilles à minuit : ultimes heures avant la Mongolie

#AVeloEntreLesLignes – Partir à la découverte du plus grand nombre de librairies possible, entre Paris et Oulan-Bator, le défi est de taille. À vélo, c'est confirmé : c'est de la folie douce. C’est pourtant l’aventure que Zoé David-Rigot et Jaroslav Kocourek ont démarrée en août 2022. ActuaLitté les accompagne, en publiant leur récit de ce périple, À vélo, entre les lignes.

01/04/2024, 08:03

Annonciation faite à Dati : les auteurs ressuscitent le rapport Racine

Devant la Comédie française, ce 25 mars – date de l'annonce à Marie de sa maternité divine –, ils étaient près de deux cents présents pour le retour d’un vieux compagnon. La première Nuit des auteurs et autrices aura vibré au son des les mariachis qui abreuvaient la place Colette de musiques. La promesse d’un rassemblement politique, collectif et festif était tenue… mais les soirées parisiennes prennent parfois des tournures inattendues.

26/03/2024, 11:56

La zone secrète entre Russie et Chine, blague de géographe

#AVeloEntreLesLignes – Partir à la découverte du plus grand nombre de librairies possible, entre Paris et Oulan-Bator, le défi est de taille. À vélo, c'est confirmé : c'est de la folie douce. C’est pourtant l’aventure que Zoé David-Rigot et Jaroslav Kocourek ont démarrée en août 2022. ActuaLitté les accompagne, en publiant leur récit de ce périple, À vélo, entre les lignes.

23/03/2024, 15:25

Sacrilège ! Une histoire française de l’offense au pouvoir

Aux Archives nationales à l’Hôtel de Soubise, du 20 mars au 1er juillet prochain, plongez au cœur de l'histoire tumultueuse du sacrilège, où le spirituel et le temporel travaillent à ne faire qu’un, mais lequel ? Le dernier discours de Robespierre, l'œil de Léon Gambetta, le testament de Louis XVI… Des trésors historiques et autres documents d'archives inédits, pour une expérience solennelle, et parfois moqueuse, aux frontières du divin et du pouvoir.

22/03/2024, 17:32

De l'Altaï russe à la Mongolie en passant par l'édition kirghize

#AVeloEntreLesLignes — Zoé David-Rigot et Jaroslav Kocourek ont entrepris un voyage en vélo entre Paris et Oulan-Bator en août 2022, avec l'objectif de visiter le maximum de librairies sur leur route. ActuaLitté documentera cette expédition en publiant le récit intitulé "À vélo, entre les lignes".

17/03/2024, 12:13

Où en est la lecture dans les campagnes françaises de 2024 ?

En février 1967, l'ORTF diffusait un numéro de sa Bibliothèque de poche, dans lequel le journaliste disparu en 2012, Michel Polac, partait à la rencontre de bergers pour discuter de leurs lectures. ActuaLitté reprend le principe à l'occasion du Salon de l'Agriculture, en interrogeant des acteurs du secteur primaire, afin de vérifier : où en est le rapport au livre dans les campagnes de 2024 ?

01/03/2024, 18:53

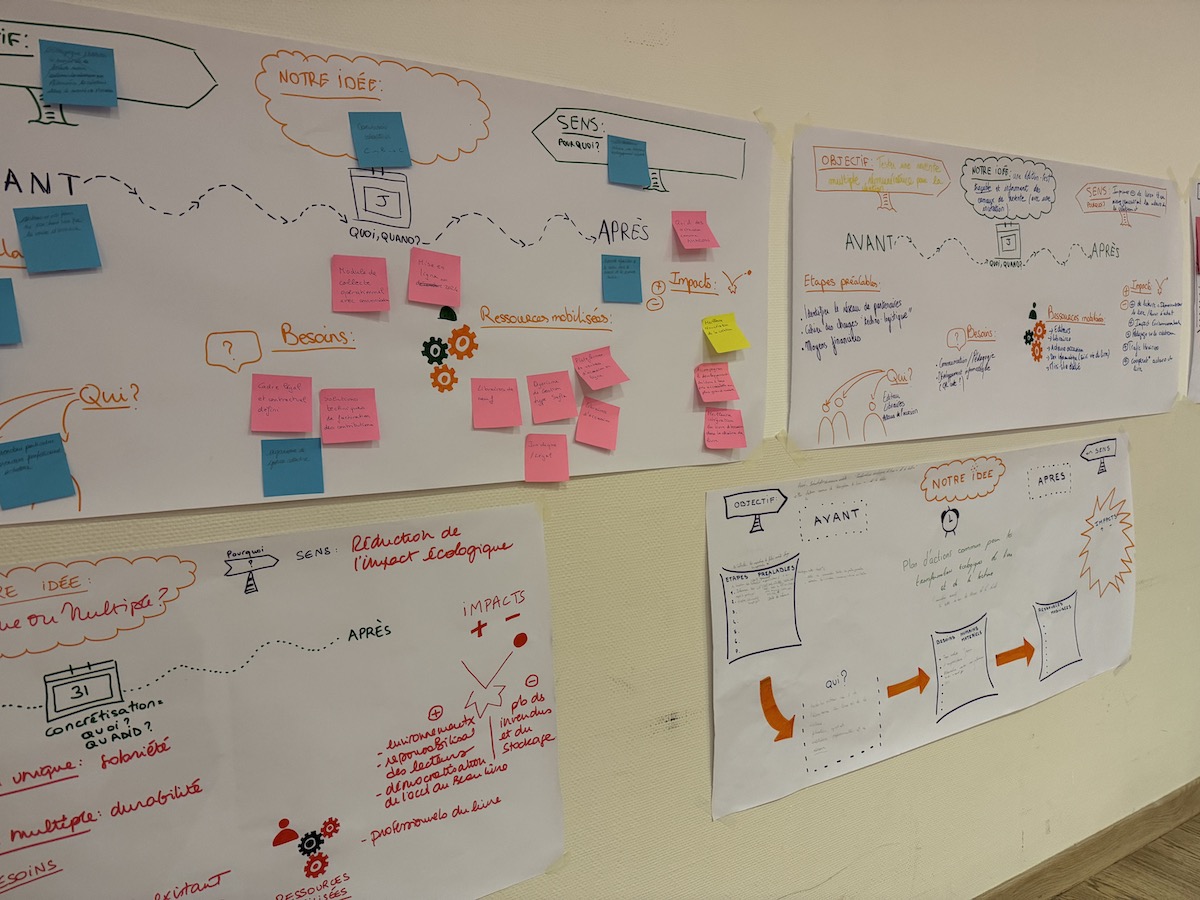

“Nutri-score” et autres projets d’avenir pour une édition écologique

D’après Erri de Luca, l’impossible caractérise « ce qui n’a pas encore été fait » (trad. Danièle Valin). La chaîne du livre — mais par cette dénomination, ne réduit-on pas ses acteurs à des maillons ignorants les uns des autres ? — était conviée à une journée de réflexion, ce 29 janvier. Dans les locaux du groupe Bayard, on se réunissait pour « décarboner le livre et l’édition ».

29/01/2024, 20:08

Centenaire de la République de Turquie (1/2) : La librairie d'Efy

Le 23 octobre dernier, les turcs célébraient le centenaire de la République turque, fondée par Mustafa Kemal Atatürk sur les ruines de l'Empire ottoman. À cette occasion, ActuaLitté propose un diptyque à Istanbul, où l'Orient rencontre l'Occident. Ville monde, trois fois née, au sept collines, vibrante d'histoires, de cultures, et de saveurs, étendue majestueusement sur les rives du Bosphore.

15/12/2023, 19:46

Thierry Fraysse (Éditions Callidor) : passés recomposés

Pour quiconque les croise en librairie, les ouvrages siglés Callidor sont de ceux que l'on n'oublie pas. Couvertures illustrées, titres calligraphiés, dessins cryptiques et intrigants cisèlent un écrin de choix pour des textes exhumés avec la patience d'un chercheur d'or par Thierry Fraysse, qui dirige la maison. Avec de la suite dans les idées, et une obsession assumée.

15/12/2023, 16:07

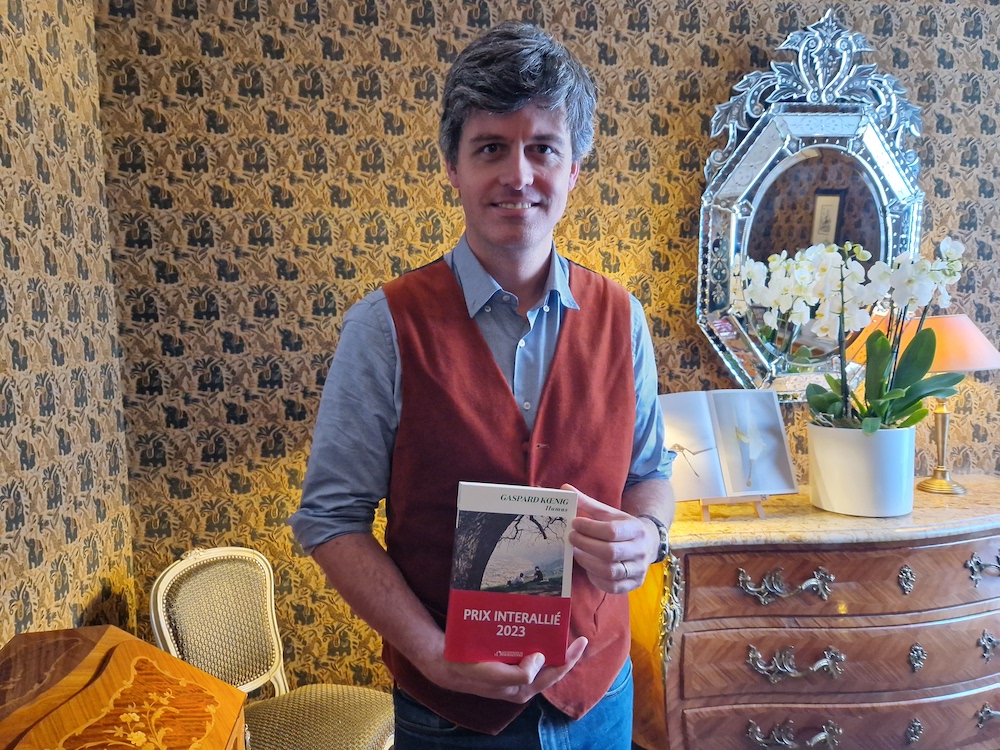

"On n’est pas non plus Miss France !”

#PrixAutomne23 - Le Prix Interallié est la dernière des grandes récompenses littéraires de l’Automne : « On a pu parfois nous reprocher d’être décerné trop tardivement dans la saison, mais cette année prouve bien que les jurys n’ont pas l'œil littéraire absolu, et peuvent se tromper… », constate le président et académicien Jean-Marie Rouart, et de continuer : « C’est pour cette raison que ce prix est né : rattraper les erreurs littéraires. » Un reproche qui s'accompagne pour certains d'un autre : avoir un jury 100% masculin...

23/11/2023, 16:34

Albin Michel inaugure sa nouvelle librairie au cœur de son Montparnasse

La Rotonde, Le Dôme, La Coupole, La Closerie des Lilas qui fut d'abord une guinguette, La Palette aujourd’hui fermée... le PDG d’Albin Michel Francis Esmenard convoque l’histoire du Montparnasse littéraire et artistique où s’est installée la nouvelle librairie Albin Michel. L’enseigne « Vaisseau amiral » de l’éditeur plus que centenaire a quitté le 229 du boulevard Saint-Germain pour s'installer 137 boulevard Raspail. Un pari, puisqu’elle a décidé d’acheter les murs, dans un des arrondissements les plus chers de Paris, et une nécessité de changer de place : le loyer avait été doublé dans l’ancien emplacement…

17/11/2023, 17:40

Monstres, strips : au couvent, une matinée de dessins

#LECfestival23 - La bande dessinée a pris ses quartiers à Cognac : le festival des littératures européennes accorde une place particulière au médium. Cette journée du vendredi, où les groupes scolaires s’ouvrent au Couvent des Récollets, édifice historique fondé au début du XVIIe siècle. En ces murs, où s’installa cet ordre mendiant, issu de la réforme franciscaine, on plonge dans les univers de plusieurs créateurs. Et à la clef, des ateliers pour apprendre à dessiner.

17/11/2023, 15:45

Maud Sarda : "Transposer en ligne l’ADN du Emmaüs traditionnel"

#LabelEmmaus - Juillet 2016, Maud Sarda co-crée la coopérative Label Emmaüs. Décembre de la même année, la Marketplace est lancée. L’ambition de celle qui est aujourd’hui la directrice générale de l’initiative sociale et solidaire ? Par l’entremise de la vente en ligne, contribuer à l’insertion professionnelle de personnes en difficulté. ActuaLitté a eu l’opportunité de découvrir le quotidien de ces travailleurs aux parcours hétéroclites, qui officient dans l’entrepôt de Noisy-le-Sec, inauguré fin 2017.

03/11/2023, 16:00

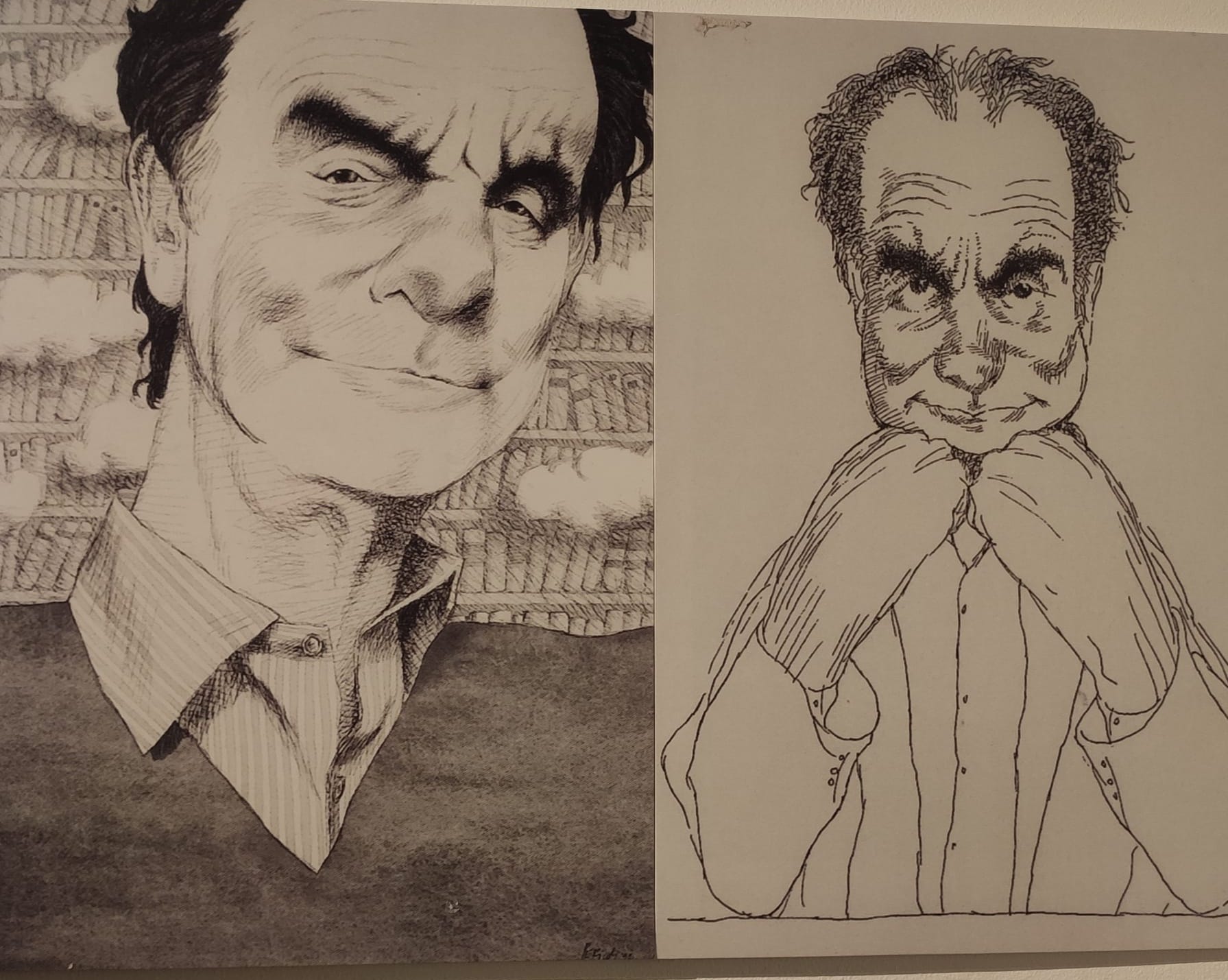

Une exposition itinérante illustre les mondes fantastiques d'Italo Calvino

Pour célébrer le centenaire de la naissance du célèbre écrivain italien Italo Calvino (1923-1985), une exposition itinérante, qui parcourra plusieurs Instituts Italiens de Culture, a été mise en place par le ministère des Affaires Étrangères et de la Coopération Internationale italien. C'est une opportunité unique de fusionner les univers imaginaires créés par Calvino avec le monde du dessin et de l'illustration.

19/10/2023, 15:47

Olivier Truc : “Le roman remplit les silences, va au plus profond de l’être”

LEP23 – Sous le beau soleil de Gradignan, Lire en Poche accueille cette année l’écrivain Olivier Truc, dont l'ouvrage Les Sentiers obscurs de Karachi vient de sortir dans la collection poche des éditions Point (288 pages, 8,90 €). Publié en grand format en octobre 2022 aux éditions Métailié, cet ouvrage revient sur l’attentat de 2002, qui a occasionné la mort de quatorze personnes, dont onze ingénieurs qui se trouvaient à Karachi, dans le cadre de la mise en œuvre d’un contrat de vente d’un sous-marin au profit du gouvernement pakistanais. Un échange modéré par Lionel Destremau, directeur de Lire en Poche.

07/10/2023, 14:40

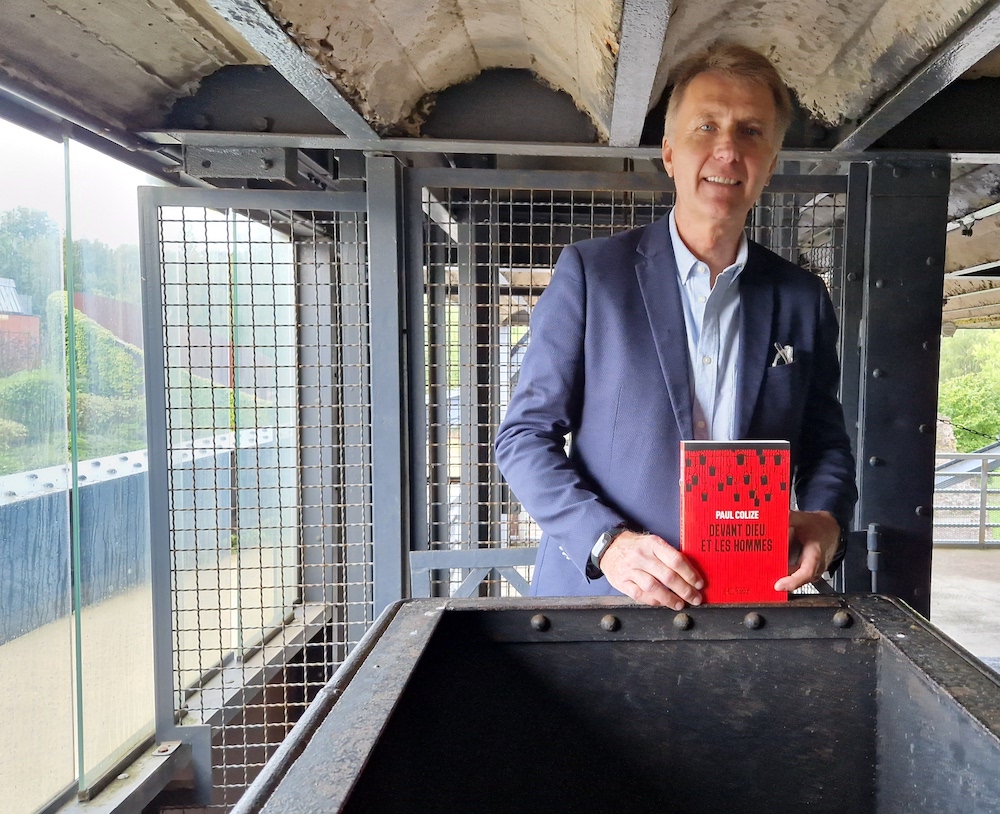

Avec Paul Colize, il y a 70 ans, le drame belge des mineurs de fond

Si en France ce drame est peu connu, il a marqué les mémoires de nos voisins du nord : le 8 août 1956, Le Bois du Cazier, une mine de charbon située à Charleroi en Belgique francophone, est victime d'un incendie. Bilan : 262 mineurs ont péri dans la catastrophe, dont 136 Italiens, faisant de l'événement l'une des plus grandes tragédies minières en Europe. Parmi les rares survivants, trois s'étaient réfugiés sous un wagonnet, se protégeant des gaz et de la fumée. Et si on avait retrouvé deux survivants et un mort...

06/10/2023, 18:40

Faire société et vivre ensemble, à travers la bande dessinée

La maison d'édition BD Bamboo, célèbre ses 25 ans à Mâcon. À cette occasion, nous avons rencontré Christine Robin, maire de la commune voisine de Charnay-lès-Mâcon, qui accueille l'événement, organisé en partenariat avec une l'Association Charnay Evenements. , pour discuter de l'impact de cet événement et de sa vision pour la commune.

30/09/2023, 12:55

Expodif, le grossiste de livres engagé dans l’économie circulaire

Expodif, le grossiste de livres neufs à prix réduit, a bien évolué depuis sa création en 1979, il y a près de 45 ans. Le principe est de racheter les stocks des invendus aux éditeurs et les revendre, avec de belles ristournes à la clé, à ses clients privés et publics : librairies, maisons de la presse, bouquineries, bibliothèques, écoles, revendeurs en tout genre, décors pour l’audiovisuel, les magasins... À présent, l’entreprise, qui a connu une impressionnante croissance grâce à son développement dans le numérique et au sein de l’économie circulaire du livre, entend progresser dans le segment des collectivités.

05/09/2023, 16:02

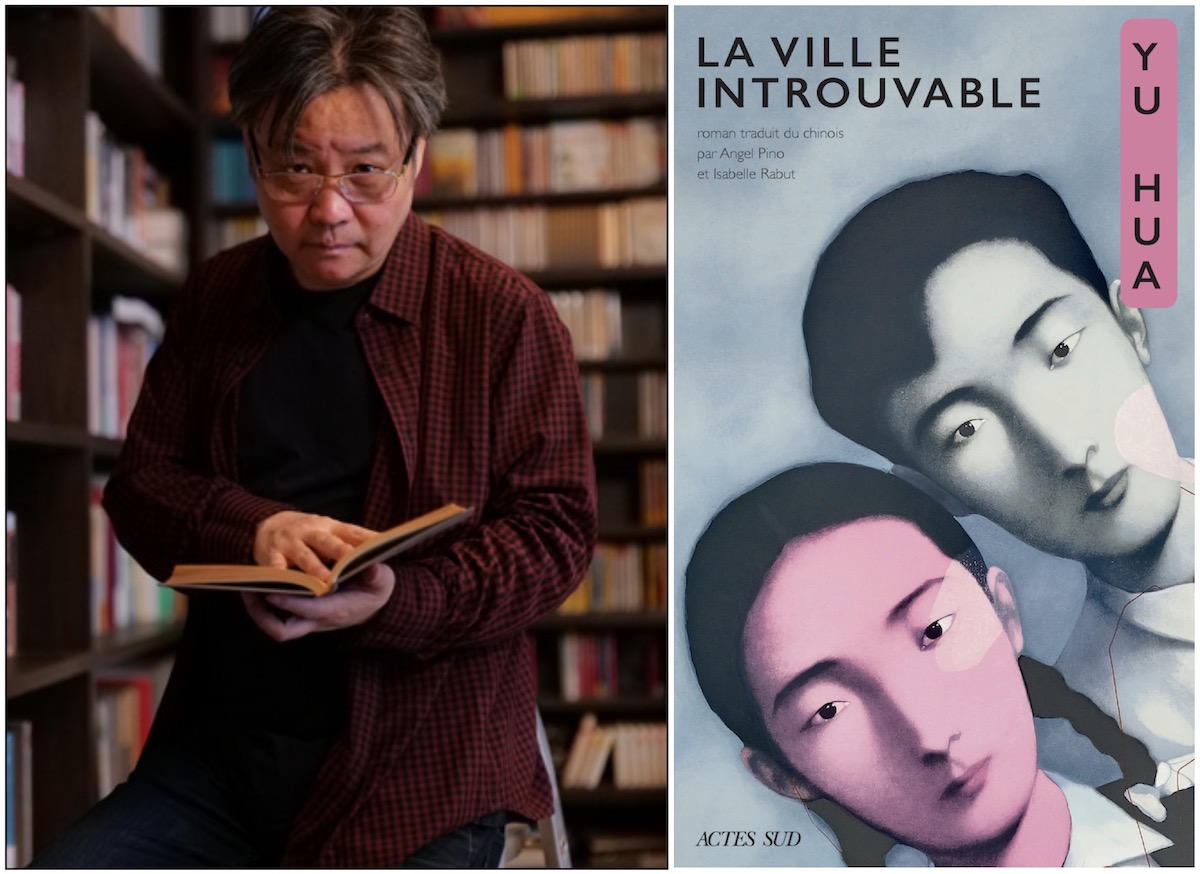

L'empreinte de Yu Hua sur la littérature chinoise

#Rentreelitteraire23 – Xavier Capodano, gérant de la librairie parisienne Le Genre urbain, est un passionné de littérature. Sa rencontre avec l'œuvre de Yu Hua, l'un des écrivains contemporains les plus reconnus de Chine, a été une révélation. Né le 3 avril 1960 dans la province du Zhejiang, l'auteur embrassa d'abord une carrière de dentiste pendant cinq ans avant de se tourner vers la littérature dans les années 1980. Une période marquée par une effervescence de la littérature expérimentale.

28/08/2023, 10:28

Sur les traces de Tolkien et de l’Imaginaire médiéval : John Howe à l’honneur

Depuis le 25 juin et durant sept mois, jusqu’au 28 janvier, les amoureux de fantasy, de Tolkien ou des contes et légendes de notre Moyen-Âge insondable, peuvent profiter de la plus importante exposition autour de l’œuvre du respecté John Howe. Le Fonds Hélène & Édouard Leclerc (FHEL), installé à Landerneau dans le Finistère, accueille près de 250 dessins et peintures de l’illustrateur canadien, de la Terre du Milieu à l’Imaginaire médiéval.

20/07/2023, 12:22

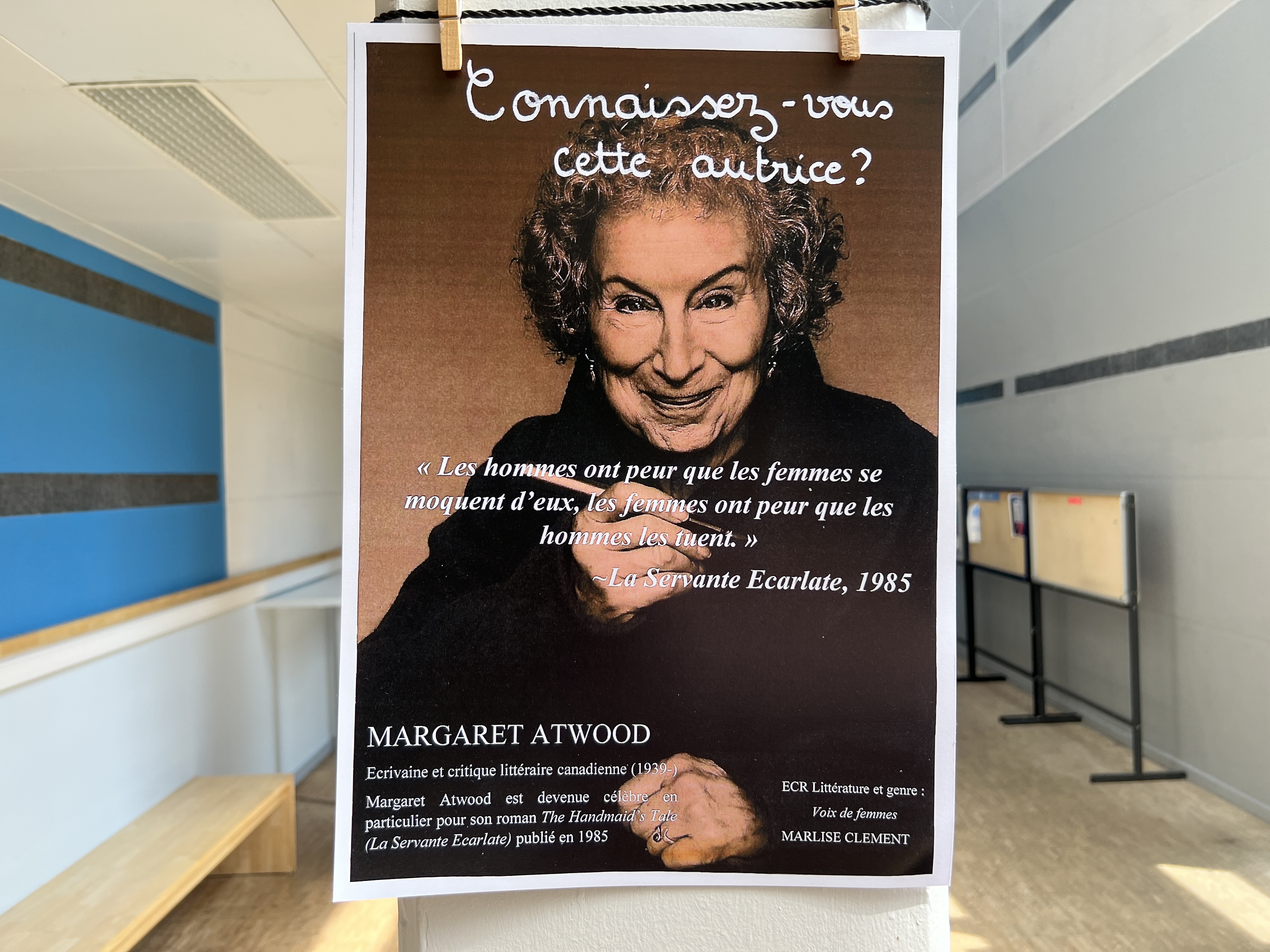

Connaissez-vous cette femme ? Elle est autrice...

Margaret Atwood, Fanny Tarnow, Svava Jakobsdóttir ou encore Kishwar Desai… Toutes autrices, et toutes affichées sur les murs de la Faculté des lettres, langues et sciences humaines d’Angers. Écrivaines connues, méconnues voire inconnues, les voilà mises en lumière par le travail des étudiants du cours Genre et Littérature.

26/06/2023, 15:09

Bulle en stock : à Amiens, la librairie engagée et passionnée

#RDVBDAmiens2023 – Rarement une librairie aura entretenu des liens si étroits avec un festival littéraire. Rarement, voire jamais, tant la relation entre les Rendez-vous de la Bande dessinée d’Amiens et Bulle en stock relève de la quasi-filiation. Si la manifestation inaugura sa première édition en juin 1996, la librairie, elle, avait ouvert en novembre de l’année précédente. Et son fondateur compte parmi les créateurs de l’événement : des bulles et des amis, CQFD.

02/06/2023, 22:01

Le roman de Dima Abdallah “réaffirme la force salvatrice de la littérature”

#PrixFrontieres23 – Pour sa troisième édition, le prix que coorganisent l’Université de Lorraine (Crem, Loterr) avec l’Université de la Grande Région (UniGR), a récompensé la romancière Dima Abdallah. Son deuxième roman, Bleu nuit, aura fait l'unanimité du jury. La présidente du prix Frontières-Léonora Miano, Carole Bienius-Penin, répond à quelques questions.

15/04/2023, 16:32

Exposition : Louis XVI, Marie-Antoinette & la Révolution

C’est à un remarquable travail collectif que nous convient les Archives nationales et les éditions Gallimard : Jusqu’au 6 novembre 2023 à l’hôtel de Soubise (Paris) est à découvrir, l’exposition gratuite Louis XVI, Marie-Antoinette & la Révolution.

03/04/2023, 11:31

Pourquoi devient-on éditeur indépendant ? Portraits

#AssisesEditionsIndépendantes23 – Éditeur, un métier de création, ou au moins de contribution à la création, on en comprendra l’attrait. Il y a les grandes structures, appuyées sur une histoire plus ou moins longue, qui est aussi celle des concentrations, et des aventures individuelles ou en petit comité. Ces dernières sont portées par des passionnés, entre succès, force de conviction et manque, parfois, de culture d’entreprise. Alors, pourquoi devient-on éditeur indépendant ?

06/02/2023, 16:27

Une Fédération des éditeurs indépendants : “J’en ai eu les larmes aux yeux”

#AssisesEditionsIndépendantes23 – La notion d’édition indépendante, qui s’est imposée dans le vocabulaire du monde du livre, se rapporte aux structures ne relevant pas d’un grand groupe. Mais encore ? Qu’est-ce qui lie Actes Sud, 9e maison française en termes de taille, et un humble éditeur de Colmar ? C’est pourquoi, à l’occasion des 1ères assises de l’édition indépendante, nous sommes allés interroger ces acteurs qui font vivre cette fameuse « bibliodiversité », et leur demander : qu’est-ce que signifie pour vous, « être indépendant » ?

03/02/2023, 09:54

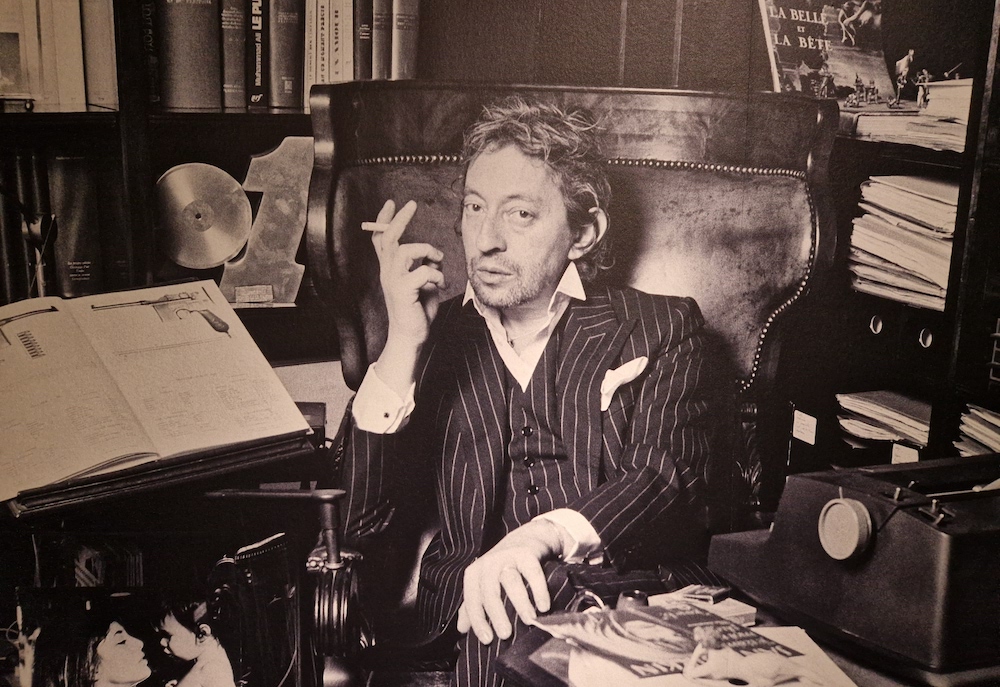

Serge Gainsbourg : portrait d'un esthète aux airs de pochtron

Ronsard 59, Le sonnet d’Arvers, Victor Hugo, Baudelaire, Musset, Nabokov… L’immense œuvre, en quantité, mais aussi en qualité, de Serge Gainsbourg, est nourrie de lectures ressassées. Gainsbourg en quête du mot exact, voilà ce que met en scène une exposition de la Bibliothèque publique d’information (BPI) depuis le 25 janvier, jusqu’au 8 mai.

30/01/2023, 14:40

L’Attaque des Titans : mise en lumière d’une œuvre colossale

#FIBD23 – Du 25 au 29 janvier se tient, à l’Alpha Médiathèque d’Angoulême, une exposition consacrée à l’œuvre maîtresse de Hajime Isayama, L’Attaque des Titans : De l’ombre à la lumière. Accompagnée de la venue de l’auteur dans l’Hexagone, il s’agit également de la première fois que ses planches sont exposées hors d’Asie. L’occasion d’explorer toute l’évolution graphique et l’émotion qui se dégage des dessins du maître des géants tétanisants.

26/01/2023, 16:52

Voyage à Auschwitz avec "la petite fille qui ne savait pas haïr"

Depuis 19 ans, le Consistoire central israélite de France organise un voyage à Auschwitz, car « la mémoire de ce crime sans nom ne peut, ne doit, être effacée » dans un contexte de hausse de l’antisémitisme. Pour cette édition 2022, sont conviés par le grand-rabbin de France, une survivante de la Shoah, des collégiens et lycéens, des religieux, des politiques, des directrices de maison d’édition et donc... ActuaLitté.

18/01/2023, 18:14

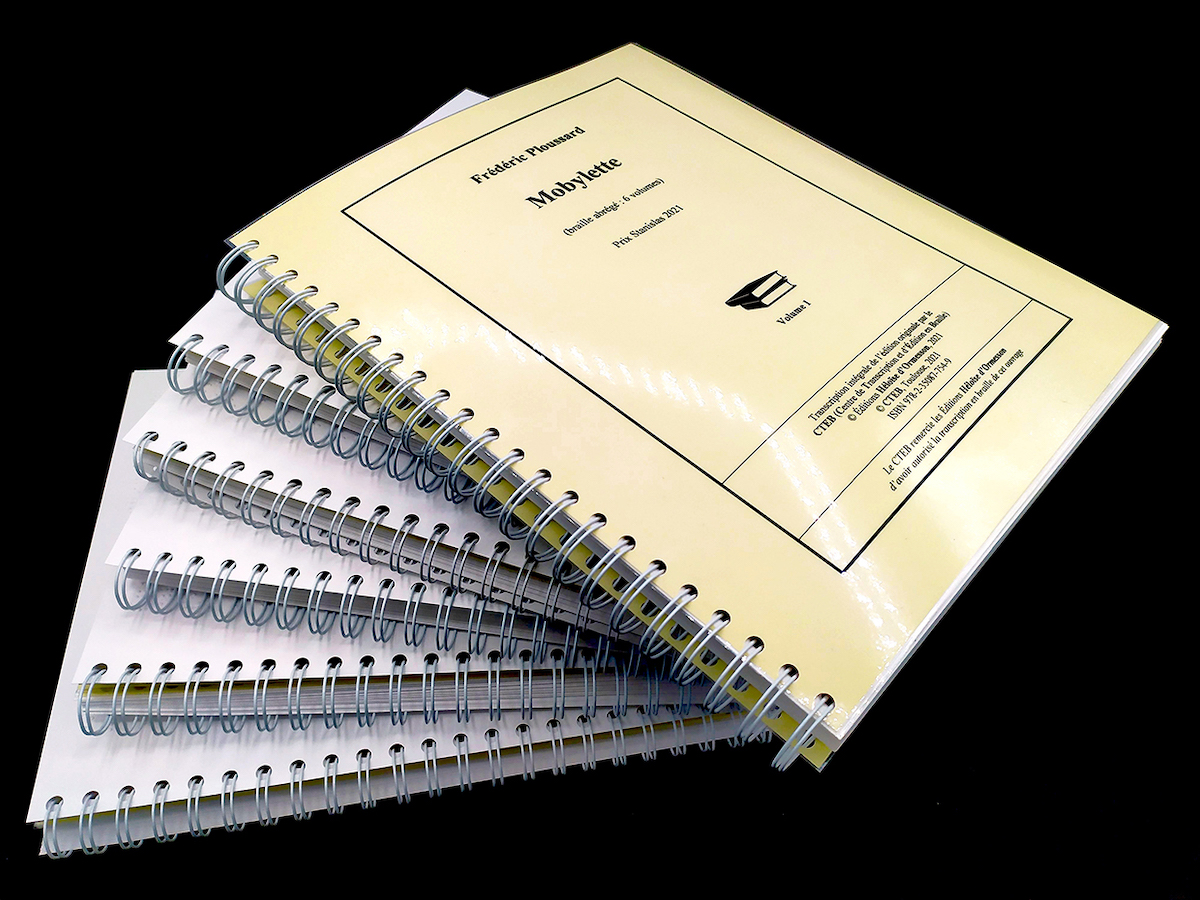

Révolution : en 2023, des livres en braille vendus au “prix unique”

Éclipsés ces dernières années par les livres audio et numérique, les ouvrages en braille restent un support crucial pour l'accès des personnes aveugles et malvoyantes à la lecture. Ces imposants volumes, très coûteux à produire, seront pourtant proposés à un tarif correspondant au « prix unique du livre », dès ce 4 janvier. Une prouesse et une garantie d'accès rendues possibles par le Centre de Transcription et d'Édition en Braille (CTEB) de Toulouse.

03/01/2023, 11:13

La science-fiction (SF), de la pop culture à “l'art contemporain”

Un lieu d’enregistrement de l’angoisse ? De révélation d’une société sous couvert d’évasion et de divertissement ? Analyse plus véritable que vraisemblable des ressorts qui transforment le réel ? Toutes ces dimensions caractérisent la science-fiction. Si la littérature, la bande dessinée et le cinéma ont été les importants réceptacles du genre, les arts plastiques ne sont pas en reste.

01/12/2022, 13:07

Du père de famille au psychanalyste : dans l'intimité de Sigmund Freud

La famille Freud vivait au rythme des consultations que Sigmund donnait dans cet appartement au coeur de Vienne. Rouvert depuis août 2020, le Sigmund Freud Museum s’inscrit dans un héritage pluriel : celui de la médecine, de l’oeuvre et de la vie quotidienne. Au coeur de l’immeuble situé au Berggasse 19, les visiteurs remontent le temps, entre publications et travaux du père de la psychanalyse.

28/11/2022, 14:51

Le château de Chantilly célèbre le “plus grand bibliophile de son temps”

À l’occasion du bicentenaire de la naissance d’Henri d’Orléans, dit le duc d’Aumale, grand bibliophile et reconstructeur du château de Chantilly, plusieurs expositions ont été organisées dans l’ancienne demeure des Condé. Depuis le 5 octobre et jusqu’au 2 octobre 2023, le cabinet des livres du fils du « roi des Français », Louis Philippe, se présente, de sa création aux plus précieux de ses trésors. Le tout sous le regard pénétrant du buste du grand Condé.

14/11/2022, 16:48

Comment la traduction a contribué à la libération des femmes

PORTRAITS – La traduction contribue à la libération des femmes depuis des siècles. Voici quelques portraits de femmes qui ouvrent la voie aux traductrices contemporaines, de Marie de Cotteblanche (première traductrice française) à Shirin Daneshvar (traductrice iranienne) en passant par Anne Dacier (première traductrice d’Homère), Claudine Picardet (première traductrice scientifique) et Clémence Royer (première traductrice de Darwin).

10/11/2022, 10:25

Des églises à l'art urbain : cheminement littéraire et historique dans Porto

LECFestival22 – Créée en 2016, la résidence d’écriture Jean Monnet est dédiée à la création littéraire européenne et accueille en priorité des auteurs émergents, en lien avec la thématique du LEC Festival. Elle est soutenue par la Ville de Cognac et dotée d’une bourse de résidence de 2000 €. Cette année, Nuno Gomes Garcia, auteur de La Domestication (trad. Clara Domingues chez IXe Editions), en est le bénéficiaire. Et il poursuit avec nous son tour littéraire et historique de Porto. (retrouver l'épisode précédent)

07/11/2022, 10:05

Autres articles de la rubrique À la loupe

La Newstalgie en littérature : quand passé et présent renouent

Voici un mot valise que le poète Jules Laforgue n’aurait pas répudié : le newstalgie. De l’anglais new, nouveau, et du français nostalgie, son acception diverge, mais l’esprit demeure : un renouvellement, qui puise dans l’ancien ses racines. Des appréciations mélancoliques qui drainent un romantisme suranné aux saveurs d’un avant, option madeleine et thé au citron, la newstalgie désignerait-elle autre chose ?

25/04/2024, 17:25

“Encore trop d’inégalités” dans l'accès à la lecture pour tous

Créée en 1917 et reconnue d’utilité publique le 27 août 1921, la Fédération des Aveugles et Amblyopes de France rassemble des militants, usagers, professionnels et bénévoles engagés pour une plus grande inclusion sociale et économique des personnes déficientes visuelles. Comme d'autres structures privées, elle s'efforce de rendre les livres plus accessibles et demande, dans une tribune, plus d'investissement des pouvoirs publics.

23/04/2024, 11:33

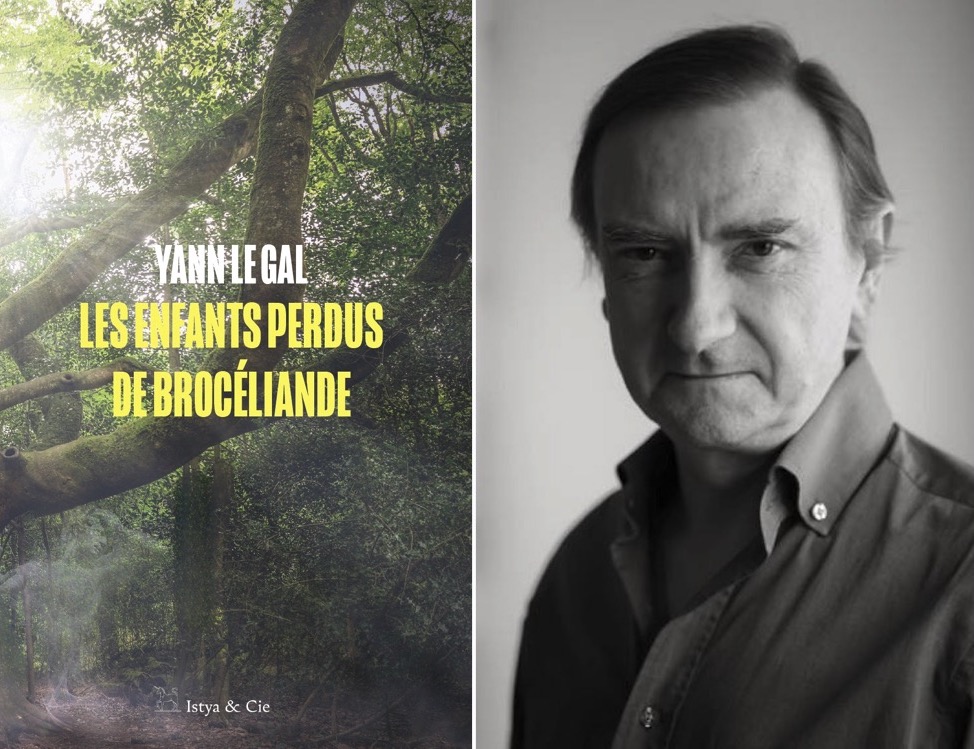

Yann Le Gal : “La librairie, c'est la passion communicative”

Agnès Martin-Lugand préside cette année le jury du Prix Maison de la Presse 2024. Depuis le 9 avril, six auteurs et leur ouvrage sont encore en lice. Le gagnant de cette 55e édition sera dévoilé le 14 mai. Yann le Gal, parmi les finalistes, profite de cette occasion pour saluer le travail des prescripteurs et ce métier de libraire.

23/04/2024, 10:45

Droit de réponse de la Maison des écrivains et de la littérature : des “accusations infondées”

Suite à un article publié le 8 février 2024 au sujet de la situation de la Maison des écrivains et de la littérature, l'association a fait parvenir un droit de réponse à la rédaction d'ActuaLitté, par l'intermédiaire du président de la structure, Julien Cendres. Nous le reproduisons ci-dessous, dans son intégralité.

22/04/2024, 11:51

La dessinatrice Elizabeth Pich a une suggestion : restons idiots

LeLivreaMetz24 – Le questionnaire de Proust est un excellent outil pour en découvrir davantage sur son écrivain préféré en un temps limité. Elizabeth Pich, autrice et illustratrice germano-américaine, a accepté de se prêter au jeu, invitée cette année du festival Le Livre à Metz.

21/04/2024, 14:52

Edwige Coupez : “C'est mon premier prix !”

J'avais oublié la légèreté d'Edwige Coupez, paru éditions du Rocher a reçu le Prix 2024 des lycéens d’Arcachon. La récompense était remise dans le cadre de la manifestation La plage aux écrivains, pour sa première édition. Les jurés venaient des lycées Grand-Air, Saint-Elme et Condorcet. L’autrice nous propose un texte inédit, sur la réception de ce prix.

21/04/2024, 12:45

Le directeur de RFI, Jean-Marc Four, face à la désinformation

LeLivreaMetz24 – Comment décrypter l’information dans un monde globalisé, nourri de milliards de données chaque jour ? C'est une des questions que se posent l'auteur de La guerre de l'Information (Tallandier), David Colon, le journaliste et grand reporter Olivier Weber, et le jeune directeur de Radio France internationale (RFI), Jean-Marc Four. Ce dernier a accepté d'évoquer ce complexe et épineux sujet auprès d'ActuaLitté, à l'occasion du festival qui allie littérature et journalisme, Le Livre à Metz.

20/04/2024, 18:20

Sylvain Prudhomme dépasse les bornes familiales

PrixFrontieres2024 – Le 6 mars dernier, Sylvain Prudhomme a été désigné lauréat 2024 du 4e Prix Frontières, pour son roman L'enfant dans le taxi, paru aux Editions de Minuit. À l'occasion de la remise de la récompense littéraire durant le Festival Le Livre à Metz, ActuaLitté a pu s'entretenir avec le Prix Fémina 2019.

20/04/2024, 14:48

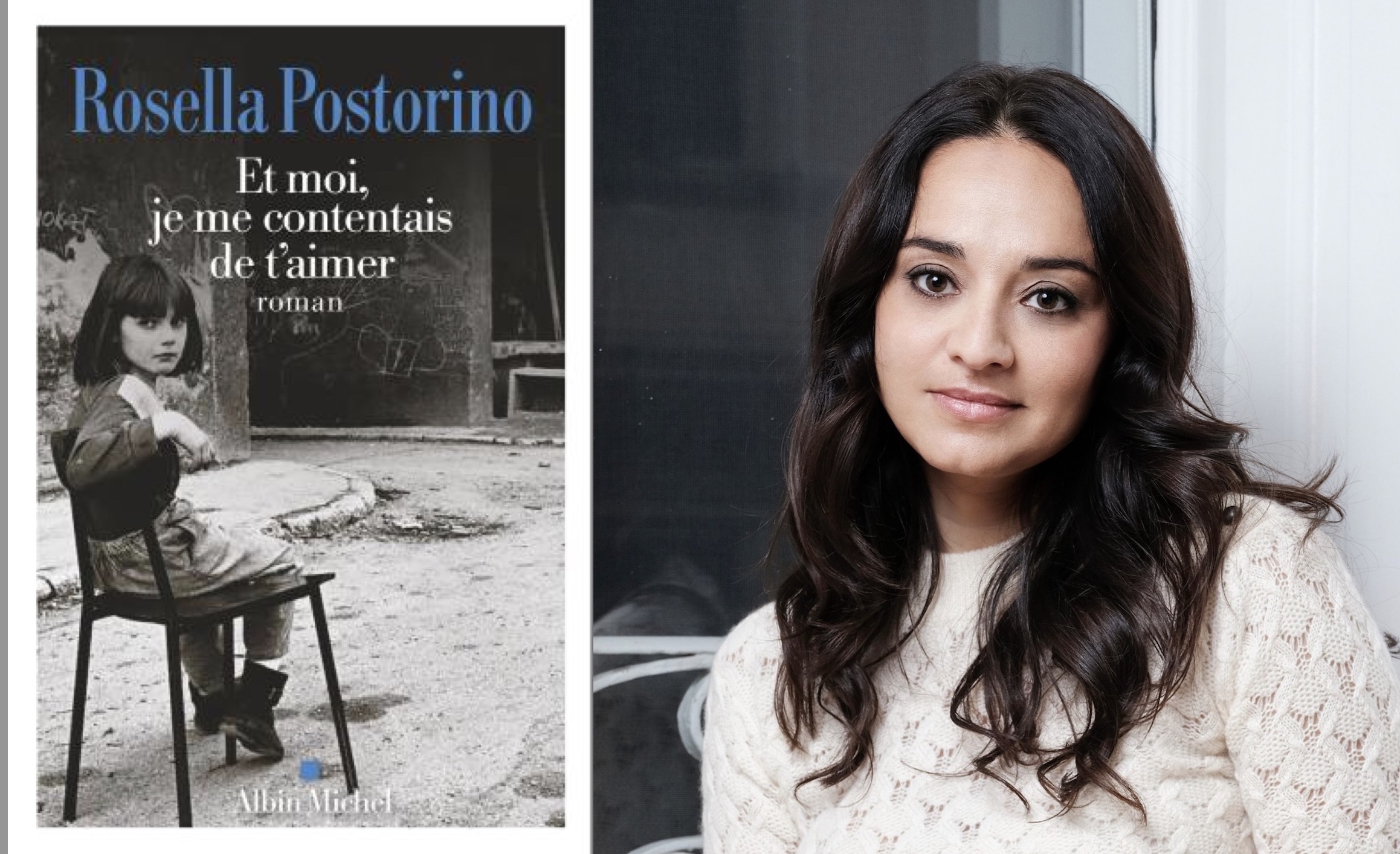

Rosella Postorino : “J’écris parce que la mort existe”

VoixItaliennes – Dans cette série d'entretiens nous donnons la parole à des écrivaines et journalistes italiennes qui s’expriment à propos de leur activité d'écriture mais aussi de leur engagement social ou politique. A travers des voix parmi les plus intéressantes de la littérature italienne contemporaine nous aurons un portrait des défis et des questions qui animent le débat culturel dans le Bel Paese.

20/04/2024, 12:56

"Dans la littérature comme le journalisme, aller au-delà des apparences"

LeLivreaMetz24 – « Gare aux apparences » est le grand thème de l'édition 2024 du festival qui allie journalisme et littérature, Le Livre à Metz. Une expression qui devrait être, - car elle ne l'est pas toujours -, un des principaux mantras du monde de la presse. C'est en tout cas l'avis de David Le Bailly, journaliste et auteur de l'Hôtel de la Folie, paru au Seuil la rentrée littéraire dernière, qui avec cet ouvrage remporte Le Prix Le Livre à Metz.

19/04/2024, 11:00

“Un prix d'autant plus précieux qu'il est décerné par des enfants”

LeLivreaMetz24 – Le prix jeunesse Graoully 2024 - à ne pas confondre avec l’ancien Graoully d'or, tourné SF - a été décerné à Marie Caudry pour son album, Ah ! Les voyages, publié chez Thierry Magnier. L’autrice recevra sa gratification littéraire à l’occasion du festival Le Livre à Metz, qui cette année alerte, « gare aux apparences »... Une expression qui va à ravir à l'œuvre ici récompensée…

19/04/2024, 09:00

Gallimard et Olivennes contre la pub pour les livres à la télé

Voilà plus de 30 ans que le sujet était plié : interdiction de faire de vendre de la publicité à la télévision pour les livres. Tout le monde s’était entendu sur le sujet, ou presque, mais l’arrivée d’un décret ouvrant la porte à une expérimentation de deux ans fait grincer des dents. Ou comment la ministre de la Culture, Rachida Dati, se met à dos les grands faiseurs de l’édition.

13/04/2024, 15:47

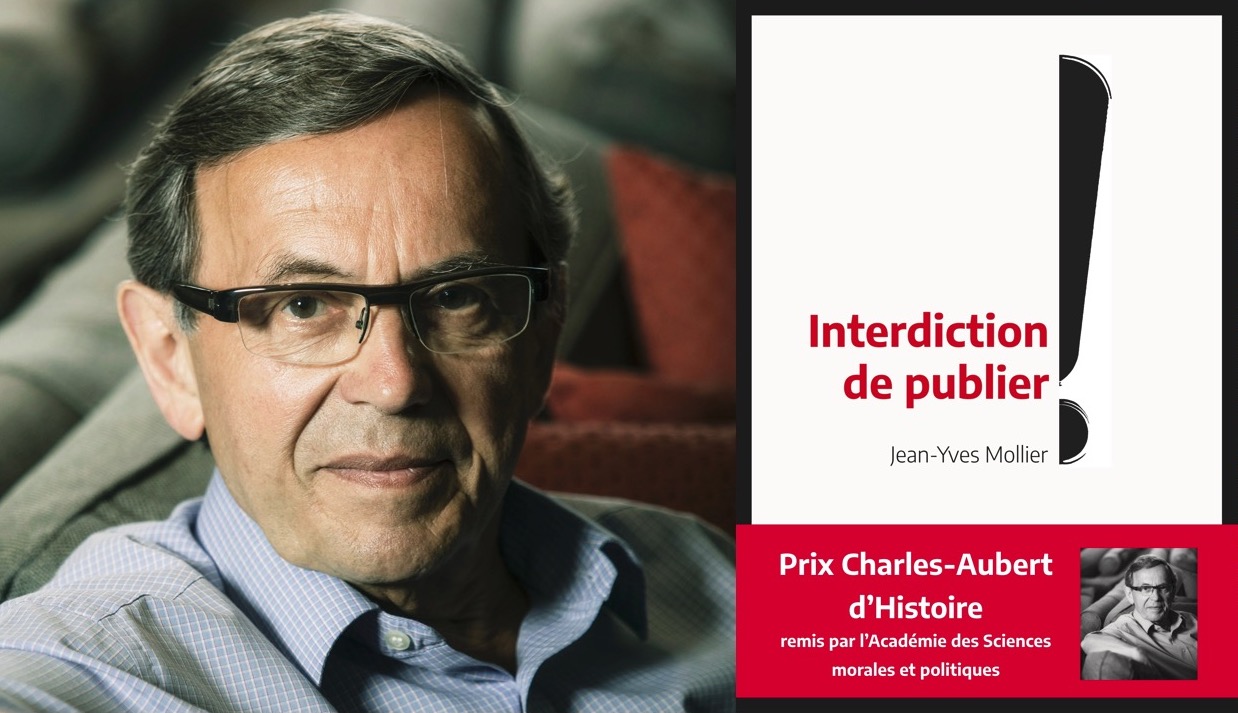

“Au Québec, la censure ne meurt jamais”, par Jean-Yves Mollier

Alors que la France s’apprête à accueillir le Québec au Festival du livre de Paris en avril prochain, et que paraît au même moment une édition revue d'Interdiction de publier. La censure d’hier à aujourd’hui (éditions Double ponctuation, 2024, Prix Charles-Aubert d’Histoire), l’historien spécialiste du livre et de l’édition Jean-Yves Mollier revient sur les différentes formes de censure du livre au Québec.

08/04/2024, 11:45

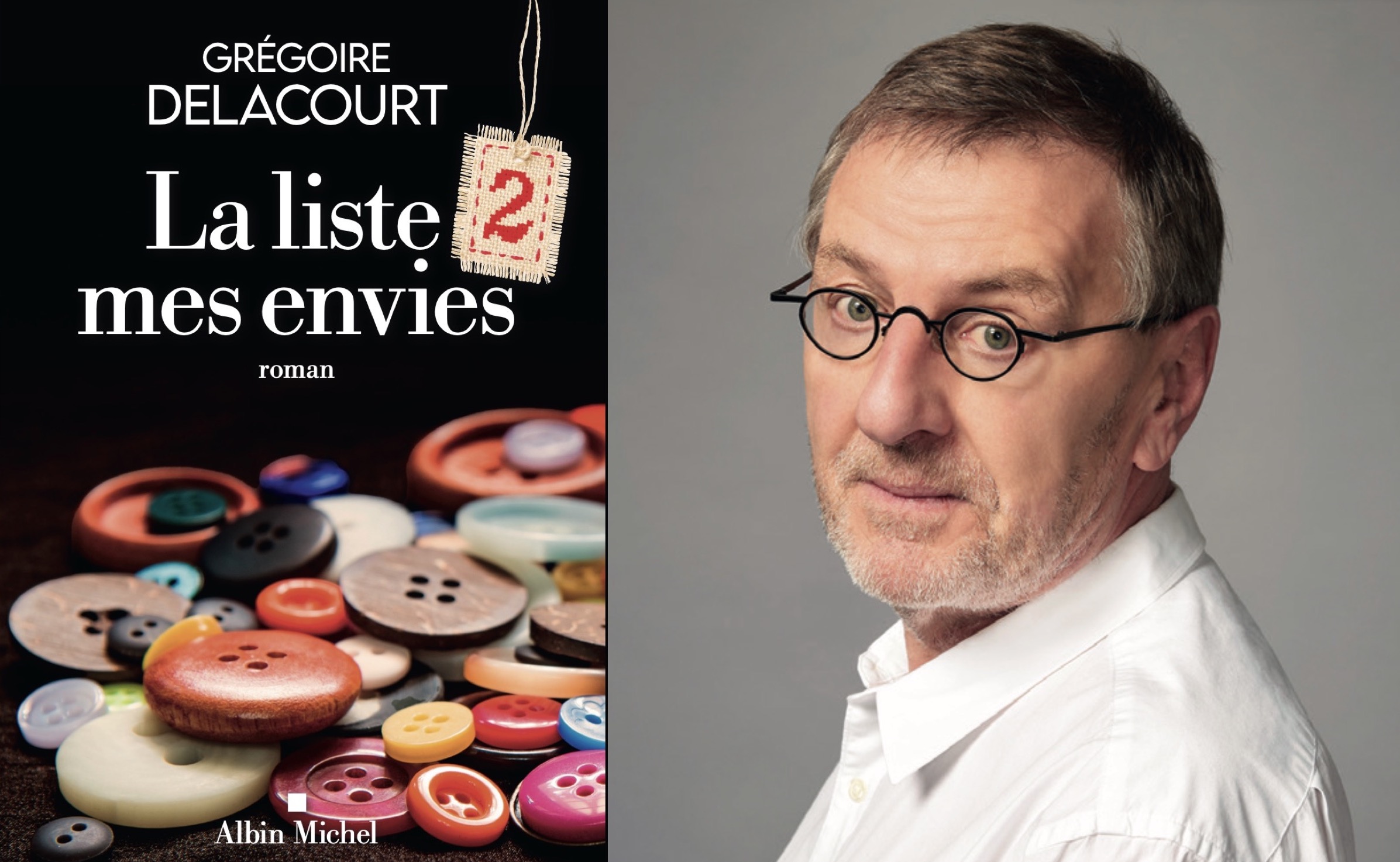

Grégoire Delacourt : “Croire en la générosité, dans une époque où l’égoïsme tue”

Dans l'univers littéraire, peu d'auteurs parviennent à tisser une connexion aussi profonde et réfléchie avec leur œuvre et leur lectorat que Grégoire Delacourt. Ce 17 avril, il publiera La liste 2 mes envies, suite des aventures de la mercière d’Arras, Jocelyne, qui avait conquis 1,5 million de lecteurs. En avant-première, le romancier évoque son parcours, son écriture et bien d’autres choses.

08/04/2024, 11:45

Glorieuse et cruelle : Tisser la langue des contes

Carnetdebord – Peau-de-Sang sera le prochain ouvrage d’Audrée Wilhelmy, romancière et artiste québécoise, que publieront les éditions du Tripode. Voici le chapitre 2 de son Carnet de Bord, tout à la fois prélude d'un roman attendu et récit d'une attente, qui nous entraîne dans un monde enchanteur.

08/04/2024, 09:48

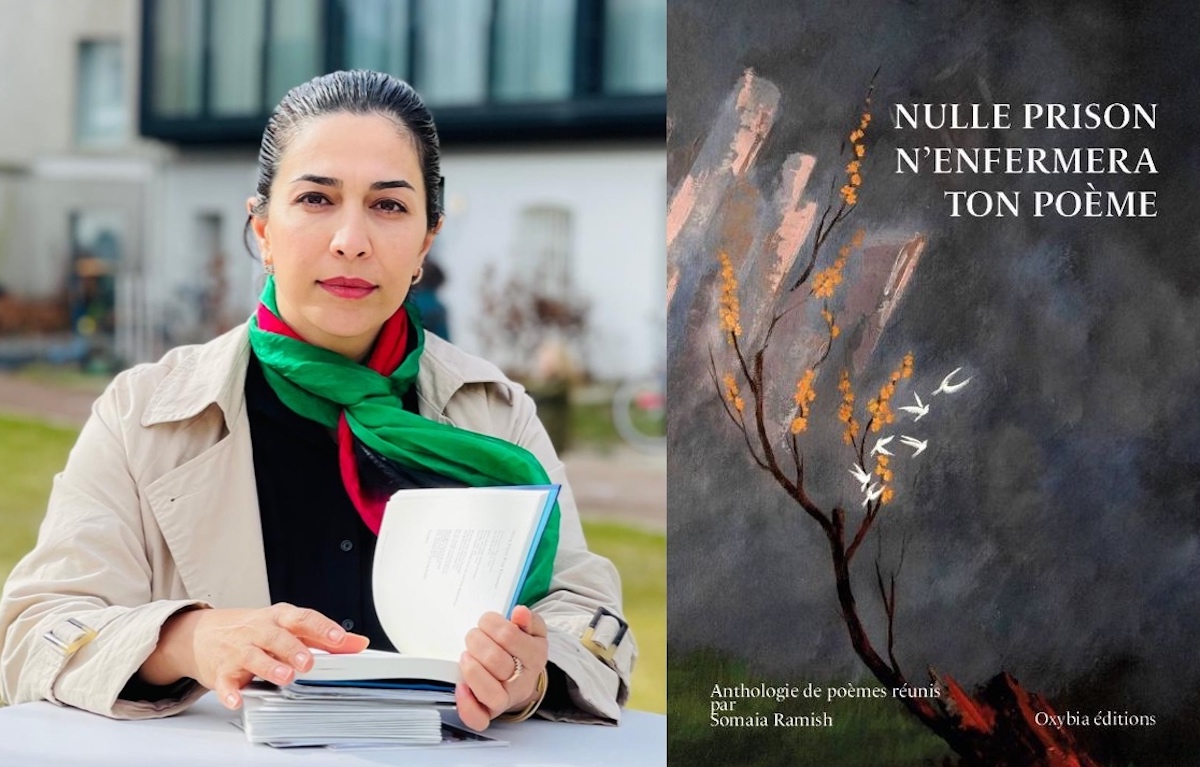

“Nous croyons que la poésie peut captiver les coeurs”

Partout dans le monde, la poésie peut exprimer l'indicible, sans en avoir l'air. Cette puissance en fait aussi une cible de tous les extrêmes, et en particulier des régimes liberticides. Dans un texte prononcé à l'Université de Lille, le 22 mars 2024, la poète, écrivaine et militante des droits des femmes en Afghanistan Somaia Ramish célèbre la poésie et appelle à la défendre, encore et toujours.

05/04/2024, 12:28

Livres pour malvoyants : “Il ne suffit pas d’agrandir la police de caractères”

La Librairie des Grands Caractères, basée dans le 5e arrondissement de Paris, publie ici son « coup de gueule » sur certains éditeurs dont les pratiques lui semblent douteuses. L'établissement pointe notamment le fait que certaines règles à suivre dans l'édition de livres pour malvoyants sont trop régulièrement ignorées par des acteurs du secteur.

02/04/2024, 13:15

Bibliocollector vise le record de cartes de bibliothèque

Adolescent lyonnais de 16 ans, Adam s'est lancé dans un projet fou : battre un record du monde en collectant le plus grand nombre de cartes de bibliothèques du monde entier. Pour que sa collection soit officiellement reconnue, plusieurs critères s'imposent, mais qu'importe, le Bibliocollector est lancé dans son projet. Entretien.

01/04/2024, 11:06

“J’habite une maison vieille qui embrasse les formes de mon corps”

Carnetdebord – Pour la rentrée littéraire 2024, les éditions du Tripode publieront le nouveau roman d'Audrée Wilhelmy. Pour accompagner cette parution, la romancière a trouvé dans nos colonnes une place à part : un Carnet de Bord pour raconter cette aventure, jusqu'aux librairies.

30/03/2024, 17:05

Pour un renouveau documentaire dans les universités françaises

L'Association des Directeurs et des personnels de direction des Bibliothèques Universitaires et de la Documentation (ADBU) et le Syndicat National de l'Édition (SNE) s'unissent pour interpeller le gouvernement et les autorités sur la nécessité critique d'un élan majeur en faveur des ressources documentaires. Ils insistent sur la nécessité d'investissements immédiats pour assurer le développement d'une documentation universitaire compétitive au niveau européen, et de maintenir la France au cœur des débats scientifiques et éducatifs mondiaux.

27/03/2024, 12:51

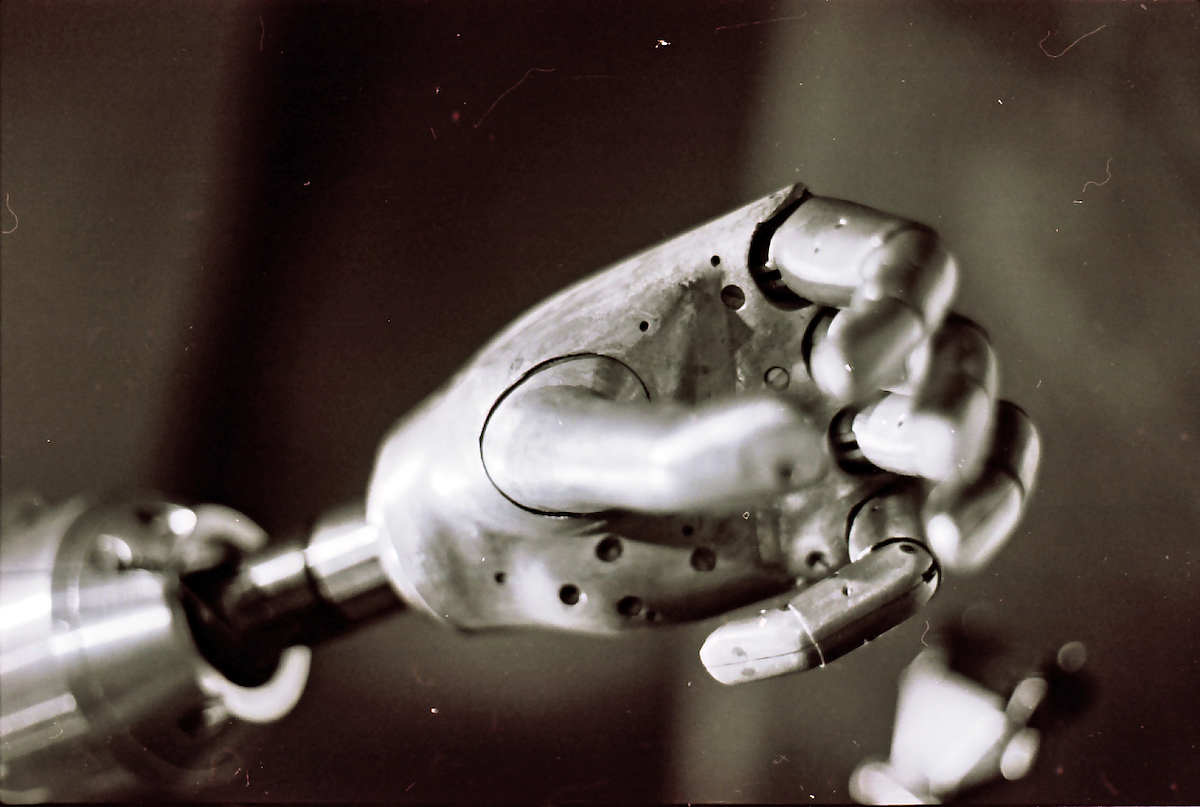

IA : un rapport “équilibré” remis à Emmanuel Macron

Alors que la « Commission IA » remettait son rapport au Président de la République le 13 mars 2024, les réactions continuent d'affluer concernant le positionnement de la France face aux enjeux de l'intelligence artificielle. Si des associations de traducteurs telles que En Chair et en Os et l'Association des traducteurs littéraires de France appelaient à sauver « le geste humain », une nouvelle tribune d'un collectif rassemblant divers acteurs des milieux culturels salue, elle, « un rapport équilibré ».

27/03/2024, 10:08

Peau-de-sang, expérience physique et sensorielle: “Bienvenue, Audrée...”

Carnetdebord – Au cours des prochaines semaines, ActuaLitté accueillera le Carnet de Bord d'Audrée Wilhelmy. Romancière québécoise, elle publiera son prochain ouvrage aux éditions du Tripode. Ce seront tout à la fois les récits d'une attente, d'un espoir, d'une envie. Ce seront les récits d'un à-venir. En guise de prélude, Frédéric Martin, fondateur de la maison, nous présente cette autrice, d'ores et déjà adoptée.

27/03/2024, 08:01

“Produire un livre écologique n’est pas possible”

La Volte annonce donc son vingtième anniversaire : vingt ans d'aventures éditoriales où se retrouvent des histoires d'émancipation, de la science-fiction sociale et politique, avec une passion pour les jeux de langage. Elle avait déjà annoncé en janvier qu'elle renforcerait cette année son engagement écologique et affirmerait son identité visuelle. Maintenant, place aux projets.

23/03/2024, 15:38

“Faire front commun face à la massification annoncée des IA dans le travail”

Après le collectif En Chair et en Os, c'est au tour de l'Association des traducteurs littéraires de France (ATLF) de réagir au rapport, IA : notre ambition pour la France, remis au Président de la République le 13 mars dernier. Ces membres, après l'avoir lu « avec beaucoup de colère », appellent les pouvoirs publics à « ne pas céder aux sirènes de la compétitivité mondiale, et l’ensemble des artistes-auteurs à faire front commun face à la massification annoncée des intelligences artificielles dans leur travail ».

22/03/2024, 13:31

Bastien Vivès, condamnable ou martyr de la liberté d'expression ?

L’Observatoire de la liberté de création (OLC) dénonce « une loi absurde et son application ubuesque » dans l’affaire Bastien Vivès. Dans une tribune, ses membres justifient leur positionnement : à chacun de se faire un point de vue...

22/03/2024, 11:26

Pour une traduction humaine : “Il en va de l'avenir de nos professions”

Quelques jours après la présentation du rapport de la commission IA au Président de la République, qui en salue les recommandations prônant le tout-IA dans de nombreux domaines, le collectif En Chair et en Os, « pour une traduction humaine », s'adresse aujourd'hui à toute l'édition, et appelle le monde du livre et de la culture à se mobiliser pour préserver le geste humain, sans céder au technosolutionnisme.

18/03/2024, 11:42

Géopolitique, conspirations : “XIII est un survivant” (Yves Sente)

AnniversaireXIII – Le plus amnésique des héros apparut en 1984, sous l’impulsion du scénariste Jean Van Hamme et du dessinateur William Vance : à la recherche d’un passé fuyant, accusé d’assassinat d’un président des États-Unis et toujours pris dans une conspiration politique sans fin, XIII fête ses quarante années d’aventures, de manipulation et de faux-semblants. Retour avec Yves Sente, le scénariste qui prolonge depuis 13 ans déjà cette épopée américaine avec le dessinateur Iouri Jigounov.

14/03/2024, 15:43

Nancy Huston : “Tout romancier qui se respecte est trans”

L'autrice française d'origine canadienne, Nancy Huston et l'écrivain, réalisateur, poète et militant écologiste, Cyril Dion, se connaissent, ils sont amis. Ils éprouvent l’un pour l’autre de l’affection et de l’estime. Les éditions Actes Sud ont proposé une rencontre pour parler de Francia, le dernier texte de Nancy Huston, publié par la maison le 6 mars dernier. Propos recueillis par Estelle Lemaître.

14/03/2024, 15:24

À Madagascar, Karné offre une évasion aux jeunes insulaires

Tout sourire et pleine d’entrain, Ravaka a l’air de fonctionner à mille à l’heure. Dès qu’elle s’exprime, on sent un grand enthousiasme et une vraie curiosité. Une envie de comprendre et d’agir se dégage d’emblée de sa personnalité positive. Elle a créé Karné, un concept unique : un magazine bilingue (malgache-français), coloré, vivant, instructif, ludique qui sait prendre sa place sur ce marché. Propos recueillis par Agnès Debiage, fondatrice d’ADCF Africa.

14/03/2024, 13:17

Expression, publication, lecture : des libertés à défendre

Depuis la Foire du Livre de Londres, cinq organisations internationales représentant les auteurs, éditeurs, libraires et bibliothécaires cosignent une déclaration. Ce texte, reproduit en intégralité ci-dessous, constitue un appel aux gouvernements et aux sociétés dans leur ensemble à veiller sur des libertés fondamentales autour des textes et de leurs auteurs : expression, publication et lecture.

14/03/2024, 11:14

Traduire par l'IA, le risque d'“un appauvrissement sensible de la langue”

Face à la montée de l'intelligence artificielle dans le domaine de la traduction, l'Association des Autrices et Auteurs de Suisse (AdS) tire la sonnette d'alarme. Lors de son 15e Symposium suisse, l'association a publié une prise de position vigoureuse, soulignant les limites de l'IA en matière de traduction littéraire et réclamant une régulation claire pour protéger les droits et la valeur du travail humain.

06/03/2024, 12:54

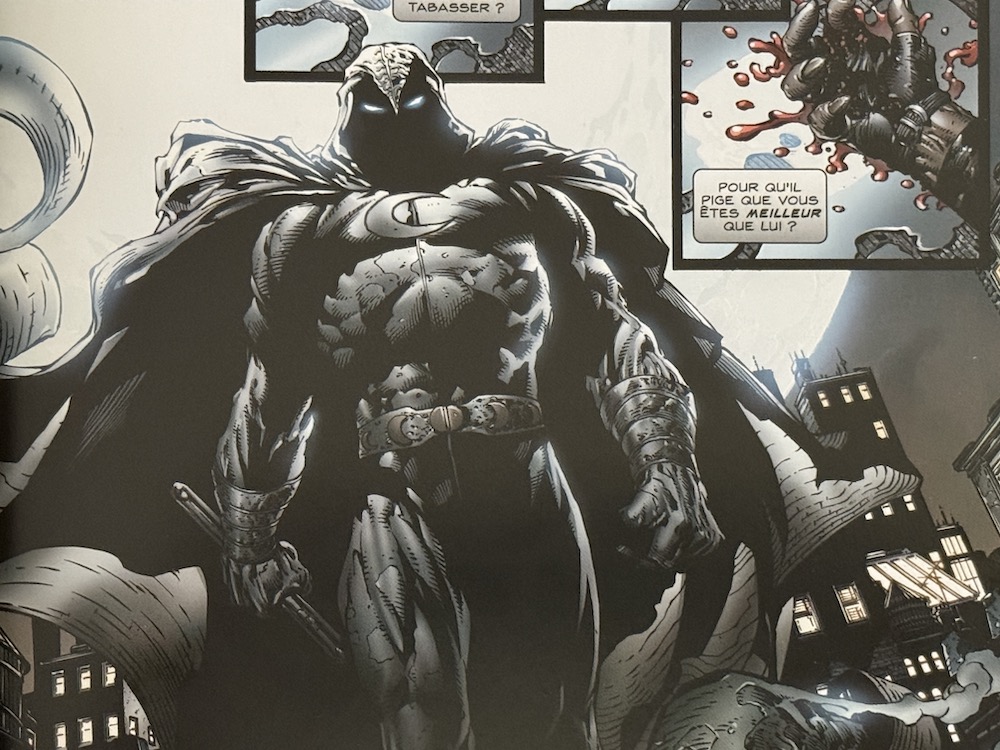

Moon Knight, justicier lunaire et passablement tordu

L’identité secrète est le propre du super héros – ça et les collants trop moulants. Apparu dans Werewolf by Night #32 en 1975, Marc Spector fêtera ses 50 ans de lutte contre le crime à New York : il protège les voyageurs, chers au dieu égyptien qui l’a choisi pour avatar. Non sans l’avoir sauvé de la mort. Mais ce personnage, atteint d’un trouble dissociatif, coexiste mentalement avec trois autres personnes. De quoi en faire un justicier atypique, dont les méthodes effraient.

06/03/2024, 12:16

Frédéric Taddeï : "L’âge est un sujet qui n’existe pas"

« Quand on vous dit que François Ier a gagné la bataille de Marignan en 1515 on ne vous dit pas quel âge il avait, il avait 20 ans ». Le présentateur Frédéric Taddeï a une obsession qu’on ne lui connaissait pas encore : l’âge. Nous l’avons rencontré pour la sortie des Birthday books le 6 mars 2024, l’occasion de discourir sur ces « quartiers de la vie que l’on habite tous ensemble ».

29/02/2024, 15:46

Plutôt BFM que CNews : Isabelle Saporta, bientôt la porte ?

Dans quel monde une salariée dénigrerait publiquement l’une des sociétés de son employeur, sans se faire tirer l’oreille ? Mieux : présenterait comme plus brillante une entreprise concurrente, du même secteur d’activité ? Eh bien… soit les anti-Bolloré reverront leur copie quant aux “méthodes” (censure, liberté de parole brimée, etc.) chez Vivendi… Soit Isabelle Saporta prépare son départ de chez Fayard ?

29/02/2024, 15:42

“Nos points communs sont simples : le territoire et le livre.”

#Noshorizonsdesirables – Durant cinq années de librairie au Québec chez Pantoute, Benoît Vanbeselaere est passé de la communication et de l’événementiel à la direction générale d’une des deux succursales. Depuis avril 2023, il a pris ses fonctions comme coordinateur de l’Association des éditeurs des Hauts-de-France. En marge des Rencontres régionales du Livre et de la Lecture 2024, à Boulogne-sur-Mer, il revient avec nous sur les actions menées et à mener.

26/02/2024, 15:13

"Les IA génératives menacent aujourd’hui l’activité des auteurs des arts visuels"

L'ADAGP l'affirme : « Les systèmes d’intelligence artificielle (IA) générative, capables de produire instantanément des contenus visuels à la demande des utilisateurs, menacent aujourd’hui l’activité des auteurs des arts visuels. » En réaction à ce constat, la société de perception et de répartition des droits d'auteur a publié une déclaration générale d’opposition. Elle s'explique dans un communiqué, reproduit ici par ActuaLitté.

23/02/2024, 17:08

Commenter cet article