data

Extraits

Théâtre

Data, Mossoul

09/2019

Communication - Médias

Toxic Data

03/2023

Romans policiers

Braquage. [Data noire

02/2021

Football

Lens Data Story

10/2021

Littérature française

Imtimité Data Storage

02/2013

Droit informatique

L'Open data

11/2023

Droit informatique

Open data et collectivités territoriales. Réussir sa démarche data

11/2021

Systèmes d'informations

Précis d'informatique décisionnelle. Data Warehouse, Data Mart, Data Vault, ODS, "étoile","flocons", Business Objects, ETL Informatica

05/2021

Histoire du sport

Data et sport, la revolution. Comment la data révolutionne le sport

08/2023

Communication - Médias

Les data contre la liberté

04/2022

Sociologie

Ainsi parlait le Big data

10/2018

Programmation

Python pour la data science

04/2022

Science-fiction

Data Song Tome 2 : Sagittarius

05/2021

Informatique

Big Data & Streaming. Le traitement streaming & temps réel des données en Big Data

07/2019

Gestion

Big Data, Smart Data, Stupid Data... Comment (vraiment) valoriser vos données. Petit manuel à l'usage de ceux qui veulent accélerer et réussir

01/2018

Science-fiction

Elecboy Tome 3 : La Data Croix

08/2022

Informatique

Big Data et Machine Learning. Les concepts et les outils de la data science, 3e édition

08/2019

Informatique

Big Data, Machine Learning et apprentissage profond

04/2019

Mathématiques

Statistical and Data Handling Skills in Biology

01/2000

Assurances

Appliquer la Data Science à l'assurance

03/2021

Actualité médiatique internati

Le petit dico critique du big data

05/2023

Informatique

Python pour la data science pour les nuls

11/2019

Programmation

Data Science avec Python. Avec Jupyter et PyCharm

03/2022

Communication - Médias

Toxic Data. Comment les réseaux manipulent nos opinions

03/2022

Entrepôt de données

Data Scientist et langage R. Autoformation aux bases de l'intelligence artificielle dans l'univers de la data, 3e édition

07/2021

Sports

Big Data Foot. Comment les datas révolutionnent le football ?

09/2019

Droit

Je prends mon poste de DPO data protection officer

07/2019

Informatique

Hadoop. Devenez opérationnel dans le monde du Big Data

04/2017

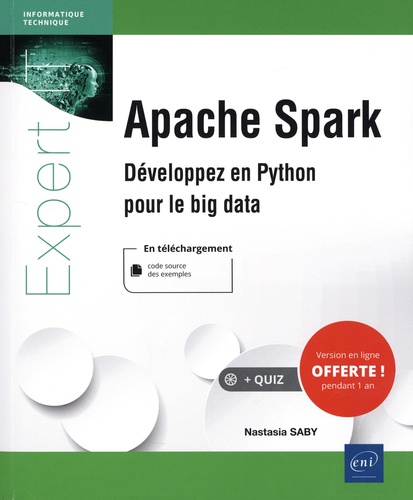

Informatique

Apache Spark. Développez en Python pour le big data

01/2022

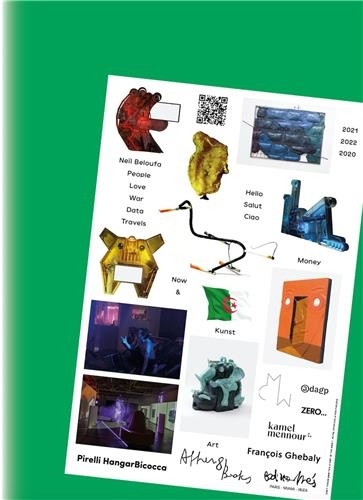

Art contemporain

People Love War Data & Travels. Edition bilingue français-anglais

09/2021